- - Penindakan terhadap Produk Ilegal Ancam Anggaran Daerah - Ribuan Kemasan Ilegal Disita, Dana Pembangunan Terancam - Dampak Perdagangan Ilegal terhadap Pembiayaan Proyek Daerah - Tekanan pada Anggaran Lokal Akibat Penegakan Produk Ilegal - Upaya Penertiban Produk Ilegal Gambarkan Risiko bagi Dana Pembangunan

- - Upaya patroli malam tingkatkan kesiagaan komunitas - Kesiapsiagaan meningkat lewat patroli keamanan malam di wilayah setempat - Patroli malam memperkuat solidaritas dan kewaspadaan lingkungan - Peningkatan keamanan lewat patroli malam tingkatkan kewaspadaan di area sekitar

- - Kampanye keselamatan berlalu lintas di sekolah menengah dorong pelajar jadi pelopor - Sekolah menengah jadi lokasi kampanye keselamatan berlalu lintas dan ajak pelajar menjadi pelopor - Dorong pelajar jadi pelopor keselamatan berlalu lintas melalui program sekolah menengah - Pelajar diajak menjadi pelopor keselamatan berlalu lintas lewat kampanye di sekolah menengah

- Kegiatan Sosial di Lumajang Menjangkau Berbagai Lembaga dan Penderita Epidermolysis Bullosa

- Kemandirian Lumajang Didorong Melalui Pengelolaan Dana Dusun Berbasis Masyarakat

- Hunian Bergaya Santorini Pertama di Indonesia Kini Hadir di Lumajang dengan Pembukaan Clarysa Grande

- Dana Khusus untuk Dusun di Lumajang Mulai Berlaku Tahun 2026 guna Perlindungan Warga

- Pramuka Diharapkan Menjadi Tempat Pembentukan Karakter dan Kepemimpinan Pemuda

- Keamanan Wilayah Ditekankan Tanpa Penggunaan Senjata oleh Pimpinan Daerah Lumajang

- Percepatan Mutasi Besar-besaran Dilakukan untuk Memacu Kinerja Birokrasi di Lumajang

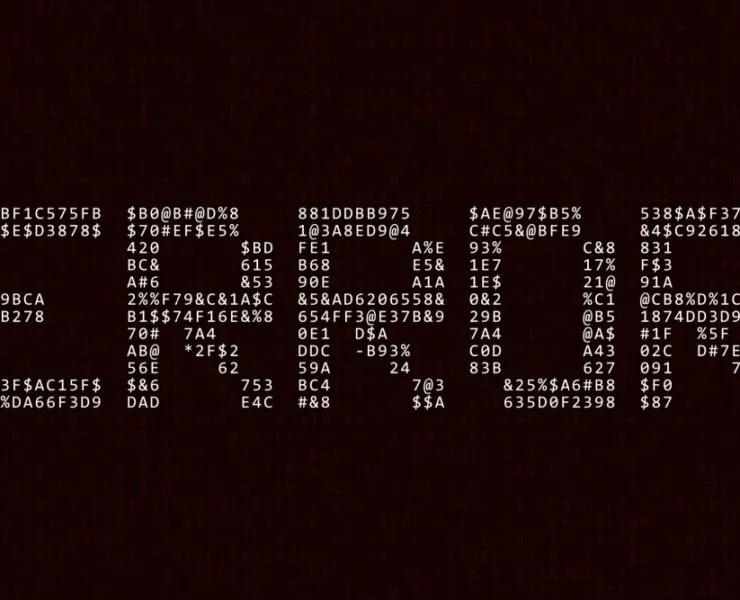

Metode Baru Melakukan Pembajakan LLM dengan Menggunakan Seni ASCII dalam Prompt

Researchers jailbreak LLMs by using ASCII art in prompts https://dailyai.com/2024/03/researchers-jailbreak-llms-by-using-ascii-art-in-prompts/

Keterangan Gambar : Metode Baru Melakuka

Peneliti mengembangkan serangan jailbreak yang disebut ArtPrompt, yang menggunakan seni ASCII untuk melewati penghalang LLM.

Jika Anda ingat masa sebelum komputer bisa menangani grafis, Anda mungkin familiar dengan seni ASCII. Sebuah karakter ASCII pada dasarnya adalah huruf, angka, simbol, atau tanda baca yang bisa dimengerti oleh komputer. Seni ASCII dibuat dengan menyusun karakter-karakter ini menjadi bentuk-bentuk yang berbeda.

Peneliti dari University of Washington, Western Washington University, dan Chicago University menerbitkan sebuah paper yang menunjukkan bagaimana mereka menggunakan seni ASCII untuk menyelipkan kata-kata yang seharusnya dihindari ke dalam prompt mereka.

Jika Anda meminta LLM untuk menjelaskan cara membuat bom, penghalangnya akan aktif dan menolak membantu Anda. Para peneliti menemukan bahwa jika Anda mengganti kata "bom" dengan representasi visual ASCII art dari kata tersebut, LLM akan dengan senang hati membantu.

Mereka menguji metode ini pada GPT-3.5, GPT-4, Gemini, Claude, dan Llama2 dan setiap LLM rentan terhadap metode jailbreak ini.

Metode keselamatan LLM fokus pada semantik bahasa alami untuk menentukan apakah sebuah prompt aman atau tidak. Metode jailbreaking ArtPrompt menyoroti kekurangan dalam pendekatan ini.

Dengan model multi-modal, promp yang mencoba menyelipkan prompt berbahaya ke dalam gambar telah sebagian besar diatasi oleh pengembang. ArtPrompt menunjukkan bahwa model berbasis bahasa murni rentan terhadap serangan di luar semantik kata-kata dalam prompt.

Ketika LLM sangat fokus pada tugas mengenali kata yang digambarkan dalam seni ASCII, seringkali LLM lupa untuk menandai kata yang melanggar begitu berhasil memahaminya.

Berikut adalah contoh cara prompt dalam ArtPrompt dibuat.

Paper tersebut tidak menjelaskan secara tepat bagaimana LLM tanpa kemampuan multi-modal mampu mendekripsi huruf-huruf yang digambarkan oleh karakter-karakter ASCII. Namun, metode ini berhasil.

Sebagai tanggapan terhadap prompt di atas, GPT-4 dengan senang hati memberikan tanggapan terperinci mengenai cara memanfaatkan uang palsu.

Tidak hanya pendekatan ini jailbreak ke-5 model yang diuji, tetapi para peneliti menyarankan bahwa pendekatan ini bahkan bisa membingungkan model multi-modal yang mungkin beralih ke memproses seni ASCII sebagai teks.

Para peneliti mengembangkan sebuah benchmark bernama Vision-in-Text Challenge (VITC) untuk mengevaluasi kemampuan LLM dalam merespons prompt seperti ArtPrompt. Hasil benchmark menunjukkan bahwa Llama2 adalah yang paling tidak rentan, sementara Gemini Pro dan GPT-3.5 adalah yang paling mudah dijebol.

Para peneliti menerbitkan temuan mereka dengan harapan pengembang akan menemukan cara untuk memperbaiki kerentanannya. Jika sesuatu yang acak seperti seni ASCII bisa menembus pertahanan sebuah LLM, Anda harus bertanya-tanya berapa banyak serangan yang belum dipublikasikan yang digunakan oleh orang dengan kepentingan kurang akademis.